Definizione di memoria cache

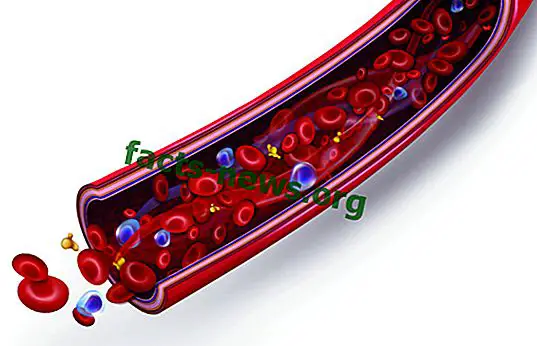

Il sistema di memoria cache è appositamente progettato per servire l'archiviazione corretta e organizzata delle informazioni su un computer. La sua funzione è sostanzialmente quella di mantenere temporaneamente e accessibili i dati necessari per eseguire determinate funzioni o attività. Questa disponibilità consente a ciascun programma o file di avere accesso immediato alle informazioni necessarie e quindi di potersi dedicare all'aumento del livello di efficienza delle normali funzioni. In questo modo, la memoria principale ha un grande aiuto che le consente di acquisire velocità di prestazione più elevate e risultati migliori al di fuori delle sue capacità limitate.

La memoria cache è normalmente strutturata in piccoli campi in cui sono memorizzati i dati necessari (fino a un byte di spazio per ciascun campo o cella). Può svolgersi come parte integrante della memoria principale e può trovarsi all'esterno e può essere attivato in modo autonomo. Tramite la percentuale di hit o il metodo di ordine medio che ogni dato riceve, viene stabilito un ordine degli elementi più richiesti e quindi diventa più disponibile, cancellando infine quelli che non vengono riutilizzati.

Quando si parla di memoria cache del disco, ci si riferisce a un processo simile alla memoria cache RAM che si verifica nella stessa memoria principale. Questa procedura è un altro modo per implementare il sistema di memoria cache, evitando di utilizzare la memoria lenta del disco rigido ma mantenendo attivo il suo interno e fornendo i dati in un modo molto più diretto.